L’ultima frontiera è l’avvocato difensore che suggerisce, via auricolari, le risposte da dare all’imputato. Non un suggeritore “umano” ma virtuale, digitale, un’app sullo smartphone. È l’intelligenza artificiale che diventa davvero utile per le persone, almeno per i diretti interessati, estremizzando il concetto di sapere al servizio degli individui. Il prossimo febbraio, negli Stati Uniti un imputato, citato per una multa per eccesso di velocità, utilizzerà il software di DoNotPay per avere suggerimenti in aula circa l’andamento della seduta. Dal canto suo, l’IA capirà e memorizzerà ogni mozione sollevata, analizzando il contesto ed elaborando le risposte che diano al cliente il modo migliore per districarsi dall’accusa. Siamo pronti per un’invasione di questi bit in varie sfaccettature della nostra vita? Lo abbiamo chiesto al giornalista, esperto di tecnologia, Antonino Caffo.

Allora Antonino, perché si parla così tanto, ultimamente, di Intelligenza Artificiale? Cosa è cambiato rispetto al passato?

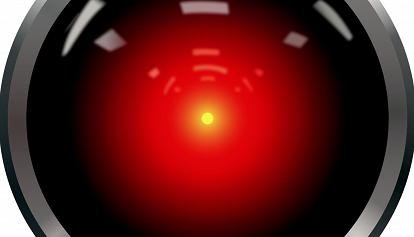

Per anni, c'è stata paura mondiale dell'intelligenza artificiale e di una conquista del mondo. Dopo mesi passati a dominare internet con il suo generatore di immagini Dall-E 2, l’organizzazione OpenAI ha rilasciato ChatGPT, un chatbot realizzato utilizzando la tecnologia proprietaria GPT-3. Non è esattamente il nome più accattivante da dare ad un “conquistatore” del mondo però il suo avvento è importante perché da a tutti i navigatori la possibilità di rendersi conto di quanto un sistema complesso possa, nel vero senso del termine, rispondere a qualsiasi domanda. Il suo clamore è stato tale da obbligare OpenAI a mettere temporaneamente offline il progetto, per troppi accessi. GPT-3 (Generative Pretrained Transformer 3) è un modello di intelligenza artificiale all'avanguardia che può generare testo comprensibile, basandosi su praticamente tutta la conoscenza umana ad oggi digitalizzata. GPT-3 offre ad un utente la possibilità di ricevere non solo risposte su argomenti ma anche indicazioni su come “scrivere” pezzi di codice, per costruire siti o risolvere problemi matematici.

E questo è un problema…

Lo è sicuramente dal punto di vista etico ma anche fattuale. Oggi qualsiasi studente potrebbe farsi spiegare da un sito web come risolvere un’equazione algebrica e forse non è del tutto sbagliato. Se quello che importa non è solo il risultato ma i passaggi per arrivarci, allora possiamo considerarlo come un aiuto sempre disponibile. Ma c’è anche il rovescio della medaglia: aziende di cybersecurity hanno già individuato centinaia di persone che, in rete, vendono programmi virus creati da zero con ChatGPT, senza avere alcuna nozione di informatica. Questo accresce, e di molto, il rischio hacking, che può sfruttare strumenti veloci e precisi per ingannare le persone. Pensiamo a quelle che oggi sono le email truffa: un mittente sconosciuto, un italiano poco corretto, una banca di cui non siamo clienti ci chiede di verificare il nostro conto. Non sono lontani i giorni in cui, tramite una AI, chiunque potrà spedire un’email che ha imparato a catalogarci, a conoscere i nostri interessi, e dunque a interagire con noi, via posta elettronica ma anche chat o WhatsApp, per fingersi qualcun altro ed estorcerci gli accessi al conto in banca, simulando la necessità di un controllo. Pochi giorni fa, i ricercatori di Microsoft hanno svelato un software che può riprodurre la voce umana da un campione di soli tre secondi. Basterà ascoltare la voce di un parente, un amico o del direttore della banca, perché questa venga riprodotta per scopi illeciti. Alcuni studiosi della Cornell University hanno analizzato le prestazioni del software, concludendo che questo supera in modo significativo i sistemi di sintesi vocale attuali. Uniamo a questo i video falsi, generati dall’IA e definiti come “deep fake” per ipotizzare un domani dove distinguere la realtà sarà molto difficile.

Però l’IA può anche essere un aiuto concreto?

Si certo. Il prossimo febbraio negli Stati Uniti un software intelligente assumerà il ruolo di "avvocato difensore” di un imputato. Da uno smartphone ascolterà quanto avverrà in aula per poi suggerire cosa dire all'accusato attraverso gli auricolari. Il caso riguarda un'udienza di routine, una multa per eccesso di velocità, ma stabilirà comunque un precedente. Negli Stati Uniti, secondo i dati riportati dal sito Cnet, l'80% dei cittadini a basso reddito non ha accesso all'assistenza legale. DoNotPay, che ha sviluppato il software, vuole dare a tutti la possibilità di difendersi.

Ci sarà mai un modo per riconoscere un umano da un supporto digitale?

Oggi è ancora molto semplice perché i supporti virtuali, sotto forma di chatbot, scrivono in maniera didascalica e non comprendono la scrittura umana se non si seguono certe regole. Ma ChatGPT dimostra che il passo successivo nell’avvicinare i due mondi è molto vicino. Gli stessi sviluppatori di Microsoft hanno affermato che ogni file vocale prodotto dal loro progetto avrà un “marchio”, una stringa di codice che lo distinguerà come riproduzione e non originale. È un modo per etichettare ciò che verrà prodotto da un artefatto in bit per non cadere in trappola ma è chiaro che tale segno distintivo dovrà essere verificabile da chiunque e al di sopra di ogni possibile contraffazione. In tal senso, tecnologie come la blockchain potranno aiutare a validare la genuinità di un prodotto, tramite archivi digitali immutabili e incorruttibili. Nel merito di ChatGPT, uno studente ha creato un'app in grado di scoprire se un testo è stato scritto da un'intelligenza artificiale. Si chiama GPTZero ed è stata realizzata da un allievo di informatica dell'università di Princeton per combattere i casi di plagio. Ancora una volta, la dimostrazione che, se lo si vuole, è possibile porre un freno alla tecnologia più rivoluzionaria, gestendone pregi e difetti. Un utilizzo a scopo illegittimo è sempre possibile ma questo non può reprimere, sin dal principio, l’innovazione che vi è alla base.